| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- timechat

- Python

- MySQL

- Server

- memory bank

- hackerrank

- CNN

- autogluon

- ma-lmm

- timestamp-aware frame encoder

- Linux

- Anaconda

- quantification

- long video understanding

- LeNet-5

- secure-file-priv

- Kaggle

- 코딩테스트

- sliding video q-former

- jmeter

- tensorflow

- q-former

- Github

- leetcode

- multimodal machine learning

- 용어

- Artificial Intelligence

- error

- 백준

- transference

Archives

- Today

- Total

반응형

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- timechat

- Python

- MySQL

- Server

- memory bank

- hackerrank

- CNN

- autogluon

- ma-lmm

- timestamp-aware frame encoder

- Linux

- Anaconda

- quantification

- long video understanding

- LeNet-5

- secure-file-priv

- Kaggle

- 코딩테스트

- sliding video q-former

- jmeter

- tensorflow

- q-former

- Github

- leetcode

- multimodal machine learning

- 용어

- Artificial Intelligence

- error

- 백준

- transference

Archives

- Today

- Total

목록memory bank (1)

Juni_DEV

[논문리뷰] MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding

[논문리뷰] MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding

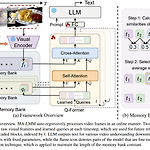

https://arxiv.org/abs/2404.05726이 논문에서는 MA-LMM(Memory-Augmented Large Multimodal Model)을 제안하여 Long-Term Video Understanding를 위한 새로운 접근법을 제시하고 있습니다. 기존의 LLM 기반 모델들이 짧은 비디오 이해에만 적합한 반면, MA-LMM은 장기 비디오 시퀀스를 온라인으로 처리하고, 이전 비디오 정보를 메모리 뱅크에 저장하여 효율적으로 분석합니다. 이로 인해 LLM의 컨텍스트 길이 제한이나 GPU 메모리 한계를 초과하지 않고도 긴 비디오를 다룰 수 있습니다.MA-LMM ArchitectureMA-LMM의 기본 구조는 크게 세 부분으로 나눌 수 있습니다.Visual Encoder: 입력된 비디오의 각 프레..

Artificial Intelligence/Paper Review

2024. 10. 20. 23:46