| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- MySQL

- long video understanding

- Server

- autogluon

- CS285

- vision-language-action

- deeprl

- Reinforcement Learning

- Kaggle

- Github

- Python

- tensorflow

- Linux

- multimodal machine learning

- transference

- Artificial Intelligence

- Anaconda

- 용어

- quantification

- hackerrank

- LeNet-5

- 백준

- ma-lmm

- jmeter

- error

- memory bank

- sliding video q-former

- leetcode

- 코딩테스트

- CNN

- Today

- Total

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- MySQL

- long video understanding

- Server

- autogluon

- CS285

- vision-language-action

- deeprl

- Reinforcement Learning

- Kaggle

- Github

- Python

- tensorflow

- Linux

- multimodal machine learning

- transference

- Artificial Intelligence

- Anaconda

- 용어

- quantification

- hackerrank

- LeNet-5

- 백준

- ma-lmm

- jmeter

- error

- memory bank

- sliding video q-former

- leetcode

- 코딩테스트

- CNN

- Today

- Total

Juni_DEV

[PaperReview] MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding 본문

[PaperReview] MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding

junni :p 2024. 10. 20. 23:46https://arxiv.org/abs/2404.05726

이 논문에서는 MA-LMM(Memory-Augmented Large Multimodal Model)을 제안하여 Long-Term Video Understanding를 위한 새로운 접근법을 제시하고 있습니다. 기존의 LLM 기반 모델들이 짧은 비디오 이해에만 적합한 반면, MA-LMM은 장기 비디오 시퀀스를 온라인으로 처리하고, 이전 비디오 정보를 메모리 뱅크에 저장하여 효율적으로 분석합니다. 이로 인해 LLM의 컨텍스트 길이 제한이나 GPU 메모리 한계를 초과하지 않고도 긴 비디오를 다룰 수 있습니다.

MA-LMM Architecture

MA-LMM의 기본 구조는 크게 세 부분으로 나눌 수 있습니다.

- Visual Encoder: 입력된 비디오의 각 프레임에서 시각적 특징을 추출합니다.

- Q-Former: 시각 인코더에서 얻은 시각적 특징을 LLM의 텍스트 임베딩 공간에 정렬합니다.

이 과정에서 Cross-Attention과 Self-Attention 메커니즘이 사용됩니다. - LLM: 마지막으로, 메모리 뱅크를 포함한 시각적 특징을 텍스트 디코딩에 사용하여 비디오 이해 작업을 수행합니다.

Memory Bank

메모리 뱅크는 MA-LMM의 핵심적인 기능으로, 비디오를 처리하면서 중요한 정보를 기억하고 활용할 수 있는 구조입니다. 이 메모리 뱅크는 두 가지 주요 구성 요소로 나뉩니다: 시각 메모리 뱅크와 쿼리 메모리 뱅크입니다. 이 두 메모리 뱅크는 비디오 시퀀스를 이해하고, 장기적인 정보의 누적과 유지에 중요한 역할을 합니다.

- Visual Memory Bank: 시각 메모리 뱅크는 고정된 시각 인코더에서 추출된 각 프레임의 원시 시각 특징(raw visual features) 을 저장합니다. 이를 통해 모델은 과거의 시각 정보를 명확하게 참조할 수 있습니다.

구체적으로, 시각 메모리 뱅크는 시간의 흐름에 따라 이전 프레임에서 추출된 시각 특징을 연결(concat)하여 저장합니다. 주어진 비디오 프레임의 역사적(historical) 시각 정보를 명시적으로 포함하고, 모델이 장기적인 비디오 문맥을 이해할 수 있게 합니다. 또한 시각 메모리 뱅크는 Cross-attention 연산에서 키와 값으로 사용되며, 입력 쿼리와의 연관성을 계산하여 과거 프레임의 정보를 현재 시점에서의 이해에 통합합니다. - Query Memory Bank: 쿼리 메모리 뱅크는 각 시점의 입력 쿼리를 축적하는 메모리 구조로, 시각 메모리 뱅크와는 달리 학습된 쿼리 상태를 계속 축적하여 시간이 지남에 따라 쌓이는 중요한 정보를 저장합니다. 이 구조는 쿼리를 동적으로 저장함으로써 현재 시점까지의 비디오에 대한 이해를 유지하고 처리할 수 있도록 돕습니다. 이를 통해 모델은 점차 높은 수준의 추상화를 통해 의미 있는 비디오 패턴과 개념을 효과적으로 포착할 수 있습니다. 쿼리 메모리 뱅크는 Self-Attention 연산에서 사용되어 입력된 쿼리 간의 상호작용을 통해 중요한 정보를 통합하고, 비디오의 시간적 문맥을 반영한 특징 표현을 생성합니다.

- Visual Memory Bank가 Query Memory Bank보다 더 나은 성능을 보였지만, 같이 사용할 때 가장 성능이 좋았습니다.

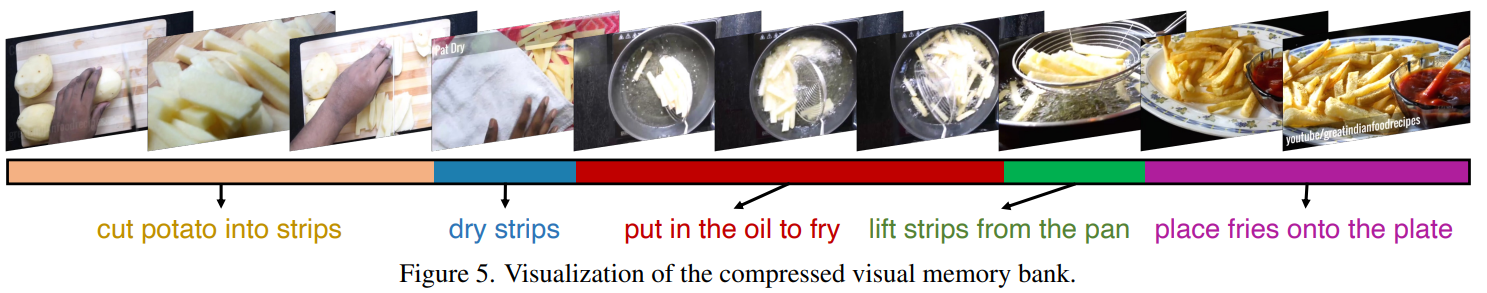

Memory Bank Compression

비디오가 길어질수록 저장해야 하는 정보의 양도 증가하기 때문에, 메모리 뱅크의 크기를 일정하게 유지하기 위해 메모리 뱅크 압축 기법이 도입되었습니다. 이 기법은 비디오의 시간적 중복성을 활용하여 인접한 프레임들 간의 유사한 특징을 토큰 병합 방식을 통해 압축합니다. 이를 통해 시간 순서를 유지하면서도 가장 중요한 시각적 정보를 보존하고, 메모리 뱅크의 길이를 줄여 효율성을 높일 수 있습니다.

각 시점에서 시각 메모리 뱅크 또는 쿼리 메모리 뱅크가 일정한 길이에 도달하면, 인접한 프레임 또는 토큰 간의 코사인 유사도를 계산합니다. 유사도가 가장 높은 프레임이나 토큰 쌍을 찾고, 이들의 특징을 평균화하여 압축합니다. 이 방법은 비디오에서 시간적 중복성을 줄이면서도 중요한 정보를 보존할 수 있습니다. 압축된 메모리 뱅크는 반복적인 정보를 제거하면서도, 시간 순서의 연속성과 중요한 세부 정보를 유지합니다. 이를 통해 메모리 사용량을 줄이고, 모델의 효율성을 크게 향상시킬 수 있습니다.

결론적으로, MA-LMM은 기존의 멀티모달 모델에서의 한계를 극복하며, 비디오 프레임을 순차적으로 처리하고 장기 메모리 뱅크에 과거 정보를 저장하는 접근법을 통해 Long-Term Video Understanding에서 뛰어난 성능을 보여줍니다. 메모리 뱅크를 활용한 새로운 구조는 기존의 멀티모달 모델에 plug-and-play 방식으로 쉽게 통합될 수 있으며, 효율적인 장기 비디오 시퀀스 모델링이 가능하게 합니다.

이 논문에서는 다양한 데이터셋에서 MA-LMM의 성능을 입증했으며, Long Video Understanding, Video Questioning and Answering, Video Captioning 등에서 최신 성능을 달성한 결과를 제시합니다. 특히, 시각 및 쿼리 메모리 뱅크의 조합과 메모리 뱅크 압축 기법은 긴 비디오를 효율적으로 처리하면서도 정교한 세부 정보를 놓치지 않는 데 중요한 역할을 합니다.

https://arxiv.org/abs/2404.05726

MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding

With the success of large language models (LLMs), integrating the vision model into LLMs to build vision-language foundation models has gained much more interest recently. However, existing LLM-based large multimodal models (e.g., Video-LLaMA, VideoChat) c

arxiv.org

https://boheumd.github.io/MA-LMM/

MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding

With the success of large language models (LLMs), integrating the vision model into LLMs to build vision-language foundation models has gained much more interest recently. However, existing LLM-based large multimodal models (e.g., Video-LLaMA, VideoChat) c

boheumd.github.io

'Paper Review' 카테고리의 다른 글

| [PaperReview] OpenVLA: An Open-Source Vision-Language-Action Model (1) | 2025.06.19 |

|---|---|

| [PaperReview] TimeChat: A Time-sensitive Multimodal Large Language Model for Long Video Understanding (1) | 2024.09.15 |

| [CNN, Tensorflow] LeNet-5 구현하기 (2) | 2022.09.21 |

| [CNN, Pytorch] LeNet-5 구현하기 (1) | 2022.09.21 |